D-LKA Attention

D-LKA Attention

论文:《Beyond Self-Attention: Deformable Large Kernel Attention for Medical Image Segmentation》(WACV 2024)

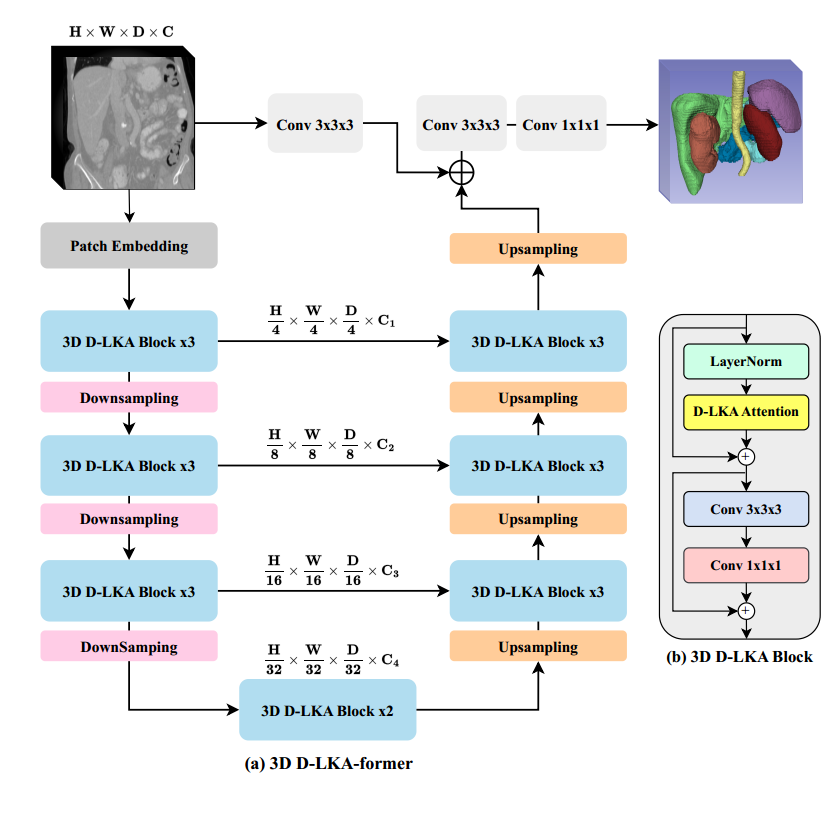

1.网络结构

网络结构:

LKA:将卷积分解为三个部分:深度卷积、深度空洞卷积和逐点卷积

LKA吸收了卷积和self-attention的优点,包括局部结构信息、长依赖性和适应性。

DW-Conv:可以利用图像的局部上下文信息

DW-D-Conv:捕获LKA中的长程依赖性方面起到了作用

1×1 Conv:通道维度中的关系

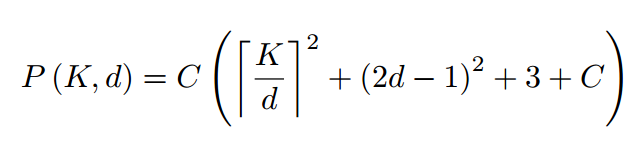

2d-LKA的参数量:

注:普通卷积kernel大小为K,DW-Conv的kernel为K/d,DW-D-Conv的kernel为(2d-1)

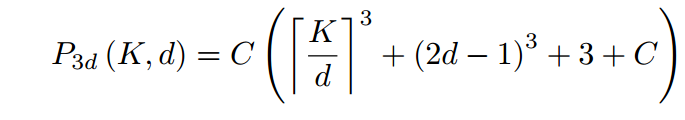

3d-LKA的参数量:

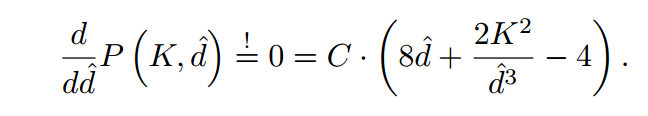

d(扩张率)是通过对参数量求导确定的,找使参数量导数为0,即参数量最小的扩张率

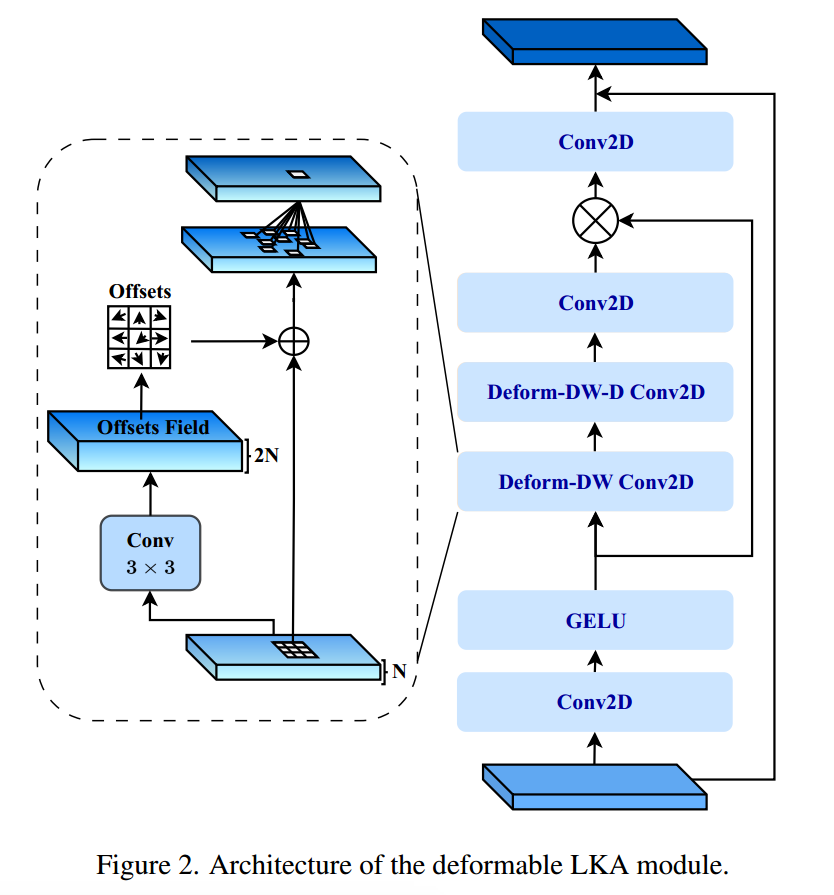

D-LKA:在LKA的基础上,使用可变形深度卷积代替深度卷积,用可变形深度空洞卷积代替空洞卷积

注:可变形卷积提高了捕获不规则形状和大小的物体的能力

D-LKA模块结构:

2.实验

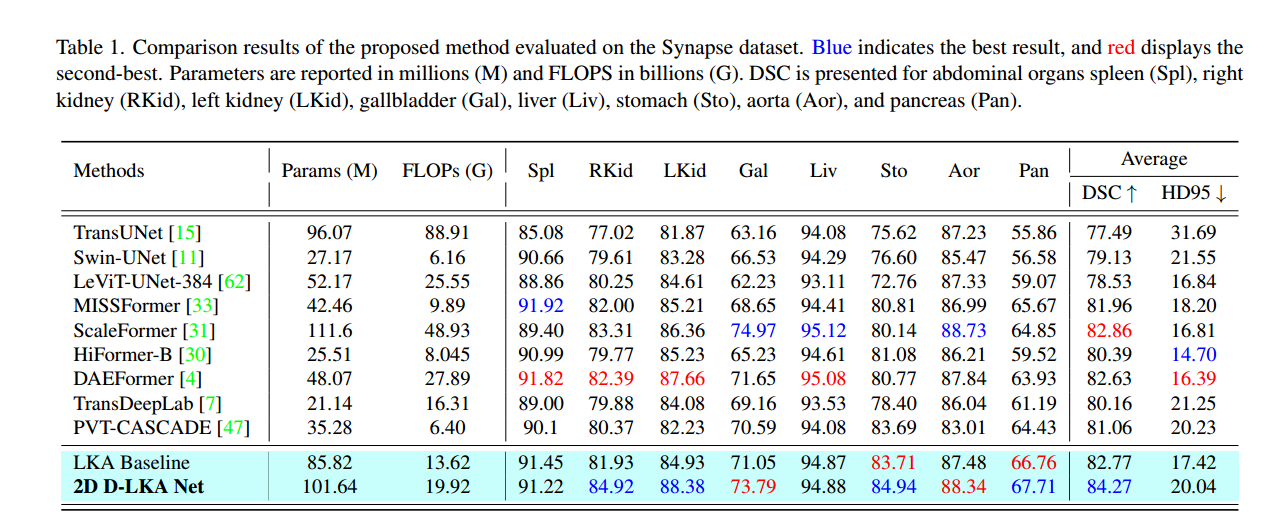

2d的D-LKA在多器官数据集上的表现:

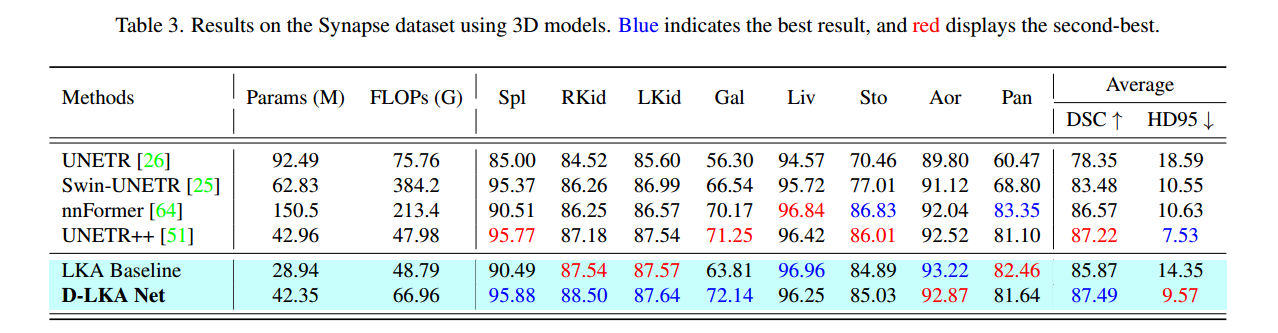

3d的D-LKA在多器官数据集上的表现:

本博客所有文章除特别声明外,均采用 CC BY-NC-SA 4.0 许可协议。转载请注明来自 丹青两幻!

评论